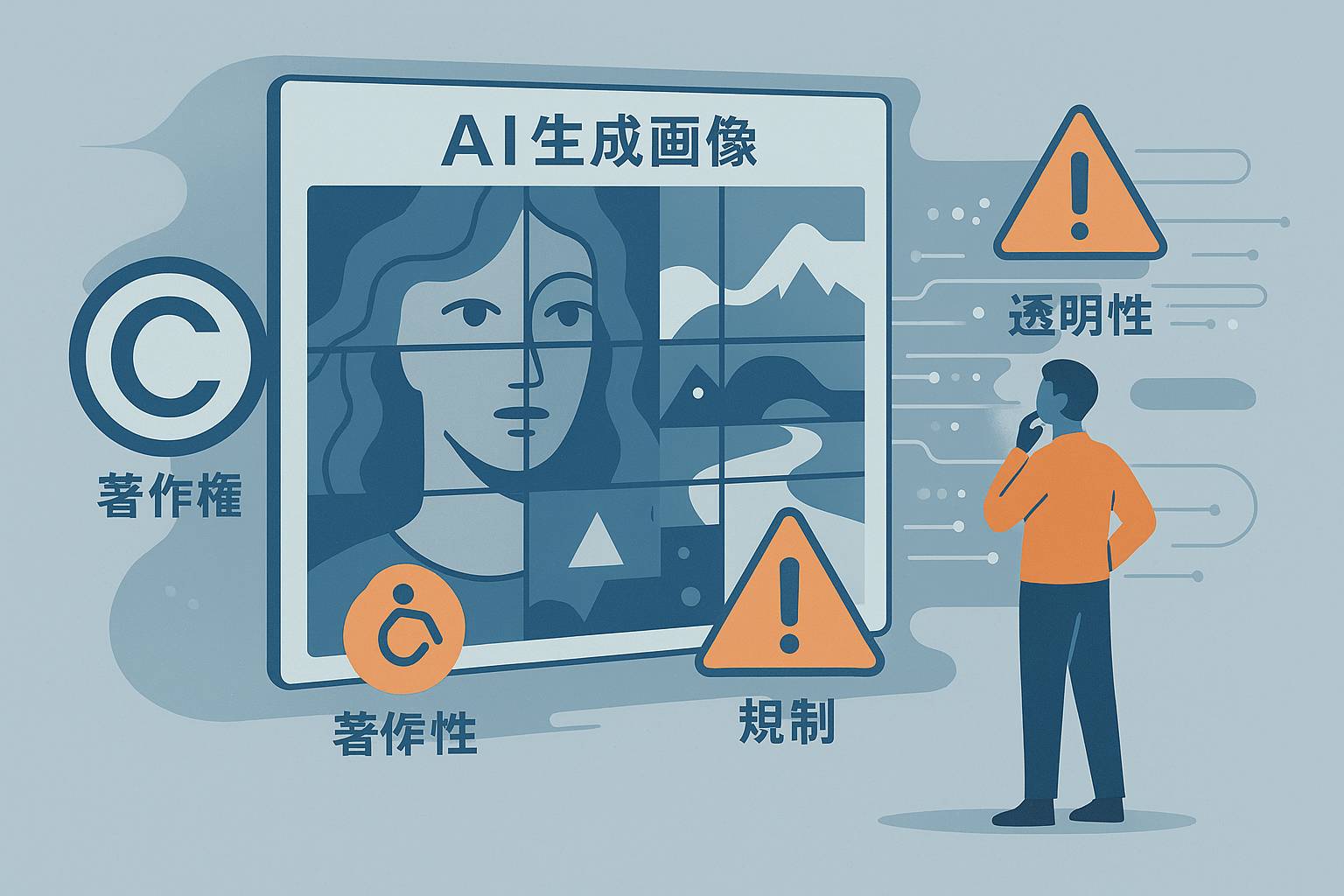

画像生成AIは短期間で劇的に表現力を高め、クリエイティブの現場やビジネス、娯楽に大きな影響を与えています。一方で、著作権や学習データの扱い、偏見や誤用(ディープフェイクなど)、労働や報酬の問題、そして透明性と説明責任の欠如といった課題も山積みです。本記事では現状の問題点をわかりやすく整理し、技術的・制度的・運用的にどう改善していくかを具体的に示します。

目次

現状の主な問題点

まずは、何が問題になっているのかを整理します。以下は代表的な懸念点です。

- 著作権と学習データの扱い:大量の画像を無断で学習に使っている例があり、権利者との関係性が不透明です。

- フェアネスと偏り:学習データの偏りが出力に反映され、特定の人種や文化を不適切に描くリスクがあります。

- ディープフェイク・誤情報:リアルな偽画像で人や出来事を誤解させる可能性があります。

- 作者の報酬と職業的影響:既存のクリエイターへの報酬や雇用への影響が懸念されます。

- 説明責任と透明性の不足:どのデータが使われ、どう学習されたかを第三者が確認できないことが多いです。

なぜこれらの問題が生じるのか

これらの問題は技術だけでなく、ビジネスモデルや制度設計、利用者行動が絡み合って発生します。主な要因は次の通りです。

- データ収集のスピード優先:量を確保するために出典確認や同意取得が不十分になりやすい。

- ブラックボックスな学習プロセス:モデル内部が見えにくく、誤りや偏りの原因特定が難しい。

- 規制の追いつかなさ:技術進化が早く、既存法規や慣習でカバーしきれない。

- 経済的インセンティブ:高速な機能提供や低コスト化が優先され、倫理的配慮が後回しになりがち。

短期で取れる技術的対策

すぐに実装可能な技術的手段を挙げます。万能ではありませんがリスク軽減に有効です。

- 生成物へのデジタルウォーターマーク:AI生成画像に不可視のタグを埋め込み、出所を追跡可能にする。

- 出力フィルタとポリシー層:暴力や差別表現、個人のプライバシー侵害を検出して出力をブロックする。

- モデルカードとデータシート:学習データの概要やバイアスに関する説明資料を公開する。

- 差分学習と削除要求対応:特定データの削除要求に応じてモデルの再学習や重み調整を行う仕組み。

制度的・法的な対応案

技術だけでは解決できない点には制度・法律の介入が必要です。

- 学習データの利用明示義務:どのデータソースを使ったかを事業者に開示させる。

- 適正な補償スキーム:既存のクリエイターに対するライセンス料や補償基金の創設。

- 利用者保護のためのラベリング規制:AI生成物であることを明示する義務化(表示ルール)。

- 責任の明確化:生成物の問題が生じたときの事業者・利用者・作成モデル提供者の責任範囲を整理。

ビジネスと社会の現実解(実装しやすいロードマップ)

技術と制度を組み合わせた現実的なステップを示します。

- 最初の6か月:透明化の標準化(モデルカード公開、生成画像へのメタデータ付加)。

- 6〜18か月:業界ガイドラインと自己規制(主要事業者の合意による行動規範)。

- 18か月〜3年:法整備と補償枠組み(データ利用の開示義務化、補償基金設立の検討)。

- 3年以上:国際協調(データ流通や基準の国際標準化)。

ステークホルダー別の具体的な提言

誰が何をすべきか、ポイントを分かりやすく整理します。

- 開発者・研究者:データの出典管理、モデルカードの整備、差分削除への対応を優先する。

- プラットフォーム事業者:生成物の明示、モデレーション体制の強化、利用規約の明確化。

- クリエイター:自身の作品の利用状況を監視し、必要ならメタデータや権利表明を強化する。

- 政策担当者:技術と市場の理解を深め、段階的な規制を設計する(透明化→責任→補償)。

- 利用者:生成物の特徴を理解し、出所表示の有無を確認する習慣を持つ。

技術対策のメリット・デメリット比較

代表的な対策を表で比較します。

| 対策 | メリット | デメリット |

|---|---|---|

| ウォーターマーク | 出所追跡が容易、検出可能 | 回避技術で消去される可能性 |

| 出力フィルタ | 即時リスク軽減が可能 | 過検出・過剰抑止のリスク |

| モデルカード | 透明性向上、信頼構築 | 詳細開示のコストや競争上の懸念 |

| 差分学習 | 特定データの削除に対応可 | 再学習コストが高い |

よくある反論とそれへの応答

反論を整理して、現実的な応答を提示します。

- 反論:規制は技術革新を阻害するのでは?

応答:透明化や最低限の表示義務はイノベーションを止めず、むしろ信頼を高める。適切なバランス設計が重要です。 - 反論:ウォーターマークは簡単に破られるのでは?

応答:単独では不十分でも、多層的な対策(ウォーターマーク+メタデータ+出力ポリシー)で実効性を高められます。 - 反論:誰が補償を負うべきか不明瞭では?

応答:事業者、プラットフォーム、利用者の役割を整理し、ケース別に責任分担を明記する法整備が必要です。

将来に向けたビジョン

理想的には、以下のような世界を目指します。

- 透明なデータ流通:学習データのトレーサビリティが確保され、権利者と利用者が互いに理解できる。

- 公正な報酬モデル:クリエイターが適正な対価を得られる仕組みが整う。

- 安心して使える生成ツール:出所表示やリスク警告が当たり前になり、悪用が減る。

まとめ:現実的な優先順位

すべてを一度に解決するのは難しいため、優先順位をつけて段階的に進めるのが現実的です。まずは透明化(モデルカード・出力表示)と利用ルールの整備(プラットフォームと事業者の責任範囲)を定め、並行して技術的な検出・追跡手段と補償制度を検討する。これが最も実効性のあるアプローチです。

ひとこと:やはり技術の恩恵を享受しつつ、生成されたこの顔って誰?とか不思議に思う事もありつつ、学習されたモノの取り扱いの難しさはまだまだ続くのかなと。

監修 NAKAMURA : 元大手企業SE兼PG、情報処理及びマイクロソフト資格保有等

監修 NAKAMURA : 元大手企業SE兼PG、情報処理及びマイクロソフト資格保有等