最近よく聞く「ディープラーニング」は、画像認識や音声認識、文章の理解まで幅広く使われています。ここでは難しい数式や専門用語を極力避けて、全体の流れと実際に役立つポイントだけをわかりやすくまとめます。読み終えると、仕組みの全体像と、何を学べば実践に近づけるかが見えてきます。

ディープラーニングって何?

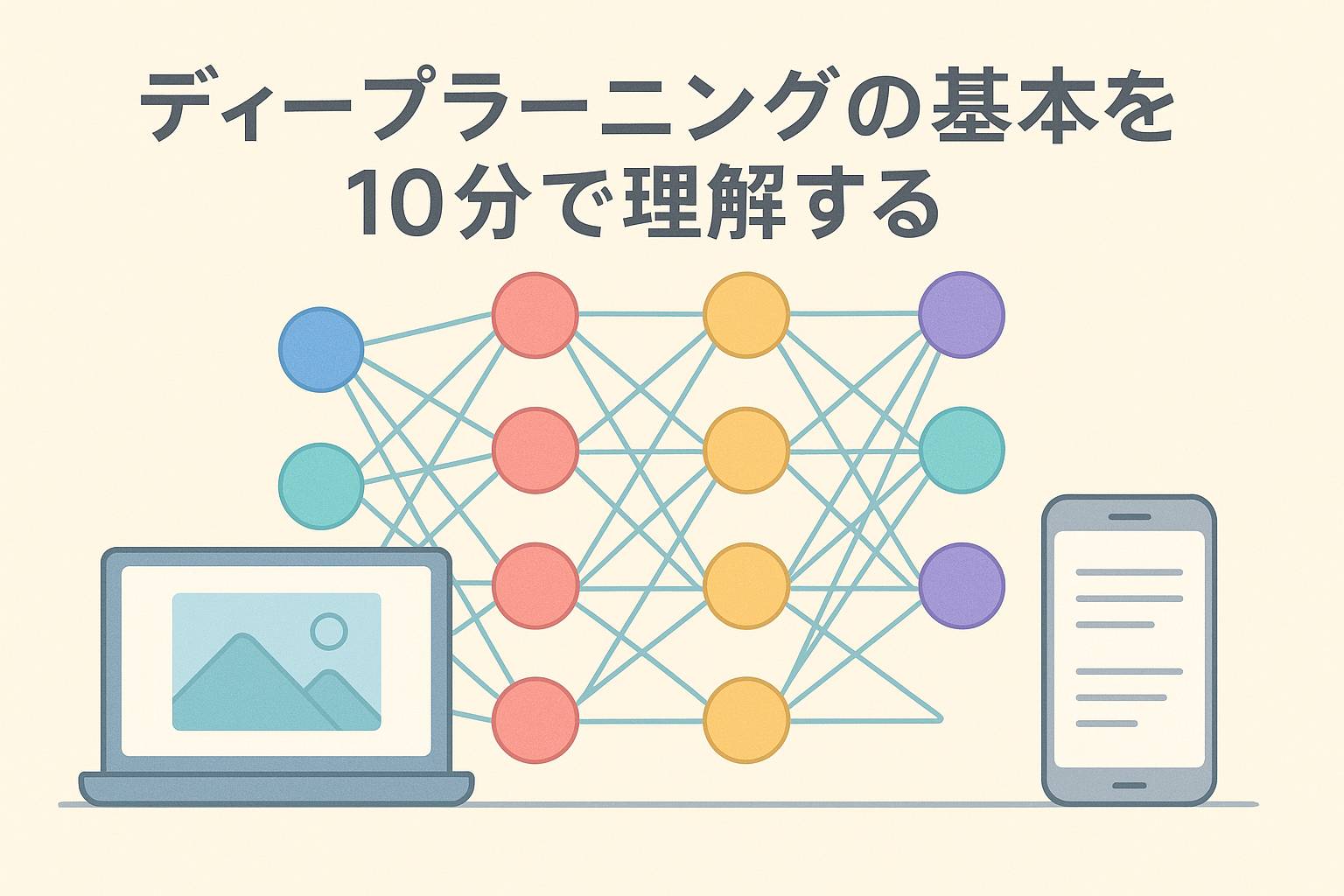

簡単に言うと、ディープラーニングはたくさんのデータから「パターン」を見つけるための方法です。従来のルールを自分で作る代わりに、コンピューターがデータを見て良い答えを出すための仕組みを自動で学習します。特に、ニューラルネットワークという構造を深く(多層に)したものを指します。

基本のイメージ:人工の「脳」を真似る

ニューラルネットワークは、小さな計算ユニット(ニューロン)をたくさんつなげたものです。入力を受け取り、層ごとに処理して最終的に答えを出します。重要なのは、つなぎ目の重み(どれだけ重要かを示す数)をデータから調整することです。

学習の流れ(全体像)

- データを用意する(画像、音声、文章など)

- モデル(ネットワーク構造)を決める

- 正しい答えと比べて誤差を計算する(損失)

- 誤差を小さくするように重みを調整する(学習)

- 繰り返して性能を上げる

この誤差をもとに重みを変えるときのやり方が重要で、ここでバックプロパゲーション(誤差逆伝播)と呼ばれる手法がよく使われます。難しく聞こえますが、要は「どの部分をどれだけ変えれば良くなるかを逆にさかのぼって計算する」仕組みです。

主要な要素をやさしく解説

活性化関数(何をする?)

活性化関数は各ニューロンでの出力を決めるルールです。これがあることでネットワークは複雑な関係を学べます。代表的なもの:

- ReLU:0未満を切り捨て、0以上はそのまま。扱いやすく速度も速い。

- シグモイド:出力を0〜1に収める。古いが解釈しやすい。

- ソフトマックス:分類の最後に使い、確率っぽくする。

損失関数(正解との差を見る)

何を目的に学習するかを決めるものです。回帰なら平均二乗誤差、分類なら交差エントロピーなどがよく使われます。目的に合わせて選びます。

最適化アルゴリズム(学習の進め方)

重みの更新に使う方法で、代表的なのが勾配下降法(SGD)と、その改良版であるAdamやAdaGradなど。学習率というパラメータが重要で、小さすぎると遅く、大きすぎると不安定になります。

よくある問題と対策

実際に使うときによく直面する課題と、その対策をまとめます。

| 問題 | 原因の見当 | 対策 |

|---|---|---|

| 過学習(トレーニングデータにだけ強い) | モデルが複雑すぎる、データ不足 | 正則化、ドロップアウト、データ増強、早期終了 |

| 学習が進まない | 学習率が不適切、重み初期化、データが不適 | 学習率調整、活性化関数の見直し、データの正規化 |

| 推論が遅い | モデルが大きすぎる | モデル圧縮、知識蒸留、軽量モデルの採用 |

代表的なモデルと用途

- CNN(畳み込みネットワーク):画像処理に強い。フィルターで特徴を自動抽出する。

- RNN / LSTM:時系列や文章など、順番を扱うのに向く(近年はTransformerが主流に)。

- Transformer:文章の処理で革命を起こした。自己注意機構で長い文脈を扱える。

実践のためのシンプルなロードマップ

- Pythonの基本を身につける(変数、関数、リストなど)

- NumPyやPandasでデータ処理に慣れる

- TensorFlowやPyTorchでチュートリアルを1つ動かす

- 小さなプロジェクト(画像分類や簡単な文章分類)を作る

- モデルのチューニングと評価を繰り返す

この順で進めれば、理論だけでなく実務で使える力が身につきます。

便利なツールとリソース

- PyTorch、TensorFlow:実装用ライブラリ

- Keras:初心者に優しい高水準API

- Google Colab:無料でGPUが使える実行環境

- 公開データセット(MNIST、CIFARなど):学習と評価の練習に最適

よくある誤解

- 「大きければ良い」:モデルサイズだけで性能が決まるわけではない。データの質が重要。

- 「データは量が全て」:量も重要だが、ラベルの正確さや前処理も同じくらい大事。

- 「専門家でないと扱えない」:基礎から段階的に学べば初心者でも取り組める。

短いまとめ(これだけ押さえればOK)

ディープラーニングは「データから学ぶ仕組み」。重要なのはデータの準備、モデルの選び方、そして学習の調整です。まずは小さな問題で試して、うまくいかない点を一つずつ潰していきましょう。

監修 NAKAMURA : 元大手企業SE兼PG、情報処理及びマイクロソフト資格保有等